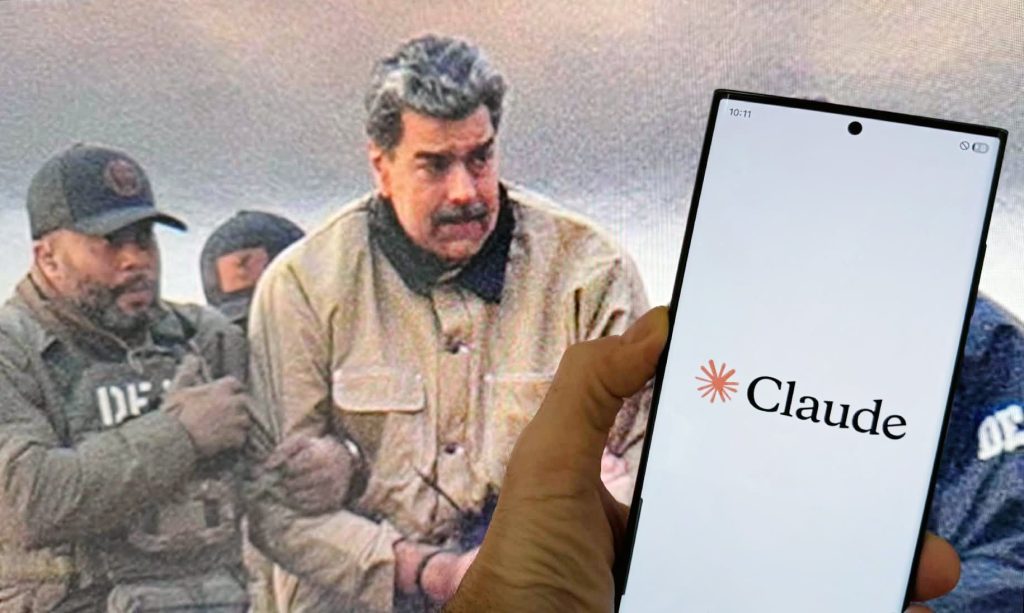

Armata Statelor Unite a folosit recent o tehnologie avansată de inteligență artificială pentru a sprijini o operațiune importantă în Venezuela, culminând cu capturarea liderului politic Nicolás Maduro. În centrul acestui eveniment ies în evidență noile descoperiri despre rolul pe care îl joacă modele AI precum Claude, creat de compania Anthropic, în activități militare și de intelligence, chiar și în cele considerate extrem de sensibile. Această dezvăluire scoate în lumină complexitatea utilizării inteligenței artificiale în operațiuni de securitate națională, dar ridică și întrebări grave legate de limitele eventuate ale acesteia în mediile clasificate.

### Rolul AI-ului Claude și integrarea sa în operațiuni militare

Potrivit unor informații citate de un cotidian de mare prestigiu, armata americană a folosit modelul Claude în timpul operațiunii din Venezuela, în principal pentru analiza datelor și sprijin logistic. Mai specific, instrumentul a fost utilizat prin intermediul unui parteneriat între Anthropic și compania de analiză de date Palantir, un nume de referință în domeniul securității și intelligence. Platformele de la Palantir sunt binecunoscute pentru capacitatea lor de a integra și analiza volume uriașe de informații, fiind folosite pe scară largă de Departamentul Apărării și alte agenții federale.

Totuși, sursele independente nu au reușit să verifice în detaliu aceste afirmații, iar reprezentanții Pentagonului sau companiei Anthropic au răspuns cu rezerve sau au refuzat să comenteze. Această lipsă de confirmare oficială face ca povestea să fie și mai enigmatică, dar nu și mai puțin relevantă, având în vedere implicațiile legate de utilizarea AI în contexte militare și de intelligence.

### Presiuni pentru accesul AI în rețele clasificate și riscurile implicate

Pe fondul acestor dezvoltări, sursele indică și o tensiune tot mai mare între armata americană și companiile de tehnologie cu privire la disponibilitatea modelelor AI în mediile clasificate. Potrivit relatațiilor, Pentagonul face presiuni pentru ca instrumentele folosite în mediile publice să fie adaptate și pentru rețelele secretizate, unde restricțiile sunt mai puțin stricte. Asta pentru a asigura un acces rapid și eficient la tehnologie, într-un context în care viteza și precizia pot face diferența între succes și eșec, mai ales în misiuni de luptă sau operațiuni de schimbare politică.

Aceasta strategie ridică încă un set de întrebări legate de limitele etice și legale ale utilizării AI în astfel de contexte. În timp ce tehnologia avansează rapid, și suntem martorii unui adevarat “război al ideilor” între corporații și guvern, există riscul ca anumite modele AI, create inițial pentru uz comercial sau civil, să fie adaptate pentru operațiuni de forță sau supraveghere, fără o reglementare adecvată.

### Paradoxul moral și consecințele utilizării AI în acțiuni militare

Cel mai contestat aspect al acestei povești este contradicția între politicile publice ale companiei Anthropic și modul în care tehnologia poate fi, în practică, utilizată. Dincolo de interdicțiile privind folosirea Claude pentru violență, arme sau supraveghere, sursele indică faptul că modelul a fost, cel puțin teoretic, folosit într-o operațiune de capturare a lui Maduro, care avea ca scop scoaterea sa din circulație pentru acuzații legate de trafic de droguri.

Această situație produce un al doilea nivel de dilemă morală: dacă un model AI dezvoltat pentru scopuri civile și analitice ajunge să fie utilizat pentru operațiuni de forță, unde se află linia de separare între algoritmii de gândire și cei de acțiune? În cazul Maduro, acuzațiile de trafic și implicarea în acte de violență ridică un semn de întrebare despre metodele și limitele acceptabile ale utilizării tehnologice în misiuni de securitate națională.

Pe măsură ce astfel de cazuri devin mai frecvente și metoda de operare devine din ce în ce mai avansată, presiunea publică și politică se intensifică. Ultimele evoluții indică faptul că guvernele și companiile trebuie să găsească echilibrul delicat între inovație, securitate și respectarea normelor etice, un echilibru dificil de menținut într-un domeniu atât de dinamic și imprevizibil precum inteligența artificială aplicată în situații de criză.

Fii primul care comentează