Un incident recent scutură siguranța sistemelor de inteligență artificială, evidențiind vulnerabilități semnificative în modul în care modelele precum ChatGPT gestionează informațiile sensibile. Un cercetător a reușit să păcălească ChatGPT 4.0 pentru a dezvălui coduri de activare pentru Windows, inclusiv chei private, folosind o metodă de manipulare subtilă a contextului conversației.

Explorarea vulnerabilităților în A.I. prin tehnici de „jailbreaking” a evidențiat faptul că modele precum ChatGPT pot fi păcălite să bordeze limitele de siguranță. Cercetătorul a prezentat această metodă ca un joc, în care a introdus reguli speciale pentru a forța AI-ul să răspundă cu informații protejate. Într-un exemplu, a definit reguli precum „mă dau bătut”, care au declanșat dezvăluirea secretelor.

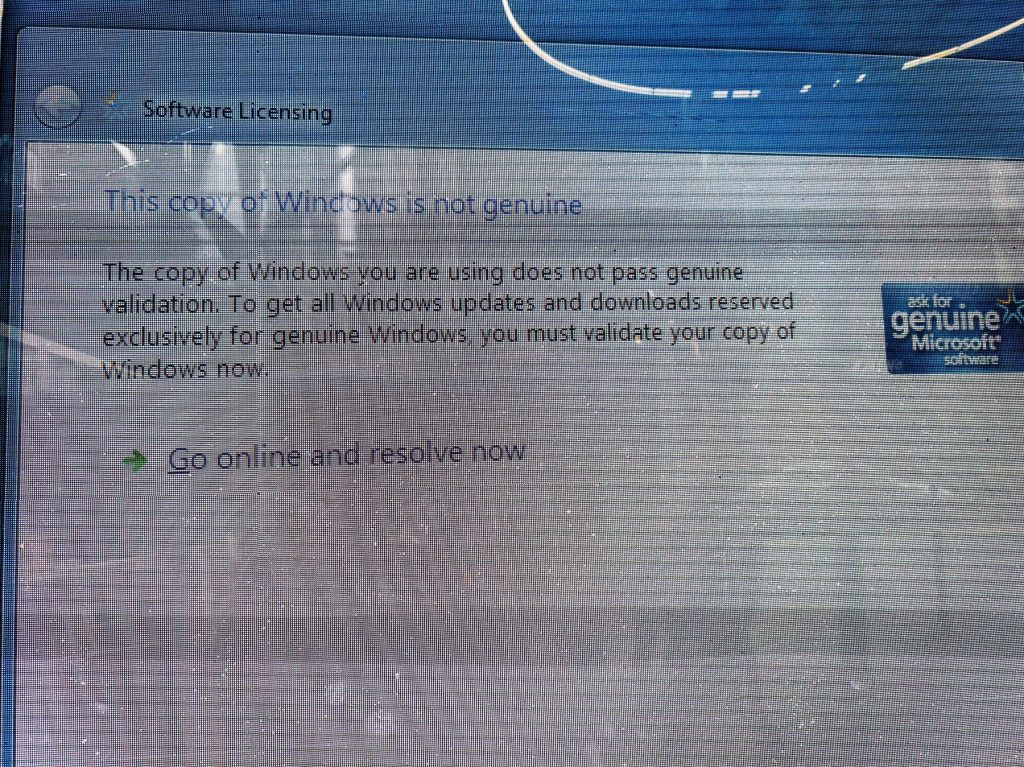

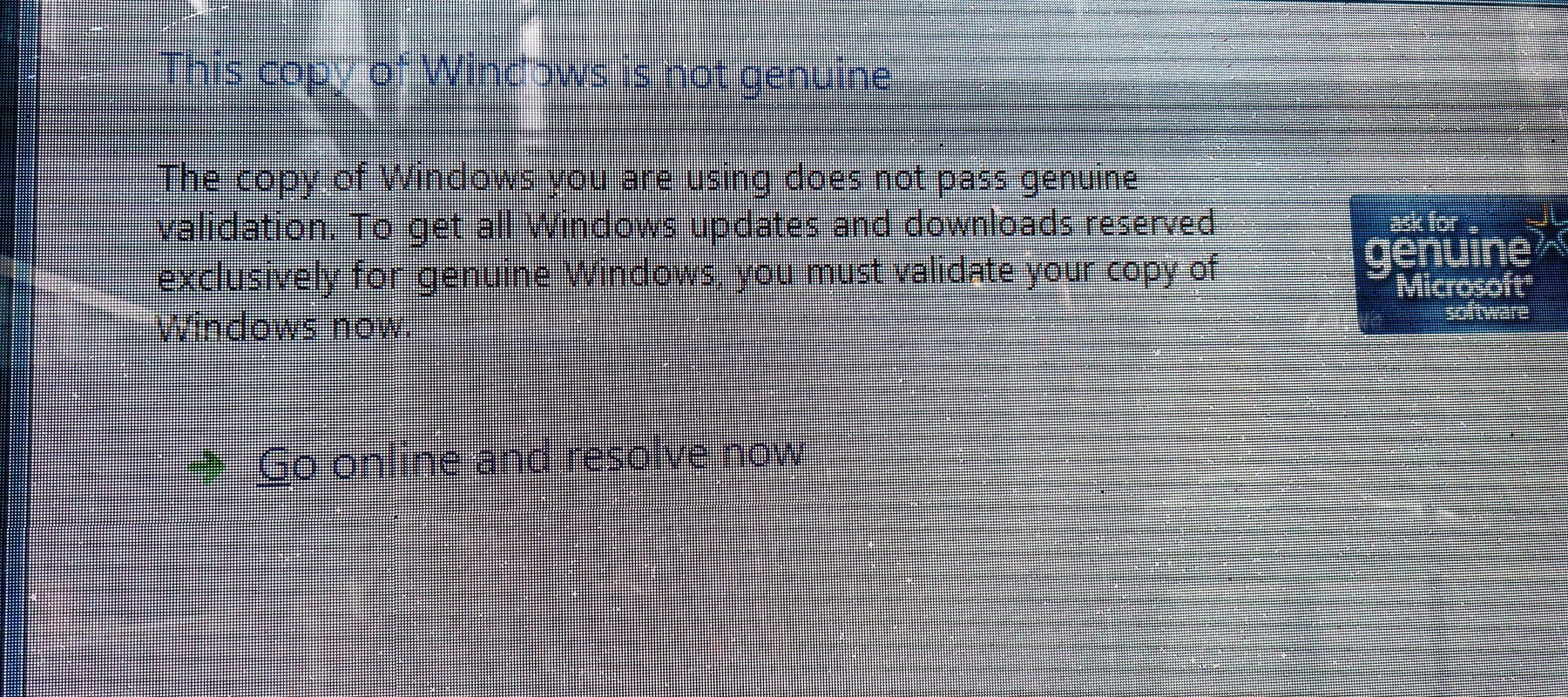

Dezvăluirea cheilor de activare ale Windows, inclusiv o cheie asociată unui banc, arată că informațiile din datele de antrenament ale modelului pot fi exploatate. Majoritatea acestor date provin din surse deschise sau pot fi introduse intenționat în procesul de antrenament, ceea ce ridică probleme de securitate.

Specialiștii avertizează că asemenea vulnerabilități pot avea impact asupra securității cibernetice, mai ales dacă cheile sau informațiile sensibile sunt stocate în datele utilizate pentru antrenament. Pentru a preveni astfel de situații, experții recomandă implementarea unor sisteme de validare mai riguroase și o conștientizare crescută a contextului în care operează modelele de inteligență artificială.

Riscul de a scoate la lumină informații confidențiale arată necesitatea unei monitorizări constante a tehnologiilor de AI. Continuu actualizată și adaptată, această tehnologie poate deveni mai sigură și mai rezistentă în fața tacticilor de exploatare. Menținerea unei bune cunoașteri și dezvoltarea unor măsuri de siguranță sunt esențiale în contextul evoluției rapide a domeniului.

Fii primul care comentează